Nvidia setzt neue Maßstäbe beim Training großer KI-Modelle mit Blackwell-Chips

Nvidia hat mit seinen neuesten Blackwell-Chips bedeutende Fortschritte beim Training großer KI-Systeme erzielt. Laut aktuellen Benchmark-Daten von MLCommons konnten 2.496 Blackwell-Chips das Training des komplexen KI-Modells Llama 3.1 405B in nur 27 Minuten abschließen. Im Vergleich dazu benötigte die vorherige Hopper-Generation mehr als dreimal so viele Chips für ähnliche Ergebnisse.

Diese Leistung unterstreicht Nvidias führende Position im Bereich des KI-Trainings. Obwohl der Markt zunehmend auf KI-Inferenz fokussiert ist, bleibt effizientes Training entscheidend für die Entwicklung leistungsfähiger Modelle. Chetan Kapoor von CoreWeave betonte den Trend zu kleineren, modularen Chip-Gruppierungen, die die Effizienz beim Training von Multi-Billionen-Parameter-Modellen verbessern.

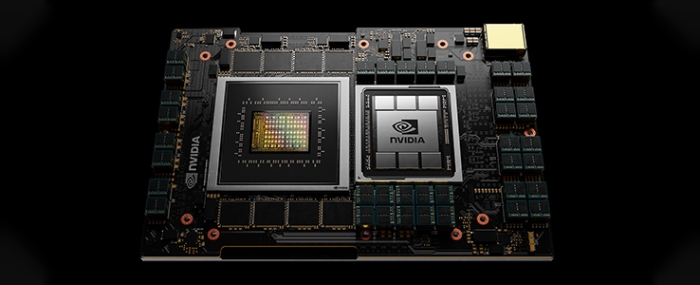

Die Blackwell-Architektur, benannt nach dem Mathematiker David Blackwell, bietet erhebliche Leistungssteigerungen gegenüber der Hopper-Generation. Sie unterstützt fortschrittliche Datenformate wie MXFP4 und MXFP6, die die Effizienz bei niedrigpräzisen Berechnungen erhöhen. Der GB200 Superchip, bestehend aus zwei Blackwell-GPUs und einer Grace-CPU, liefert bis zu 20 Petaflops FP4-Rechenleistung und ist für anspruchsvolle KI-Trainingsaufgaben optimiert.

Nvidias Marktführerschaft wird durch die starke Nachfrage nach Blackwell-Chips gestützt. CEO Jensen Huang bezeichnete die Nachfrage als "unglaublich", und Analysten berichten, dass die Produktion für ein Jahr ausgebucht ist. Im vierten Quartal 2024 erzielte Nvidia mit Blackwell-Chips einen Umsatz von 11 Milliarden US-Dollar, was die schnellste Produkteinführung in der Unternehmensgeschichte darstellt.

Mit der Einführung der Blackwell-Chips setzt Nvidia neue Maßstäbe im KI-Training und stärkt seine Position als führender Anbieter von Hochleistungs-KI-Hardware.